サム・アルトマンが来日したね。

誰それ?

え?!サム・アルトマンを知らないの?それは相当やばいよ。

サム・アルトマンは、今話題のChatGPTをつくったOPenAIという団体のCEOだよ。

へー、そうなんだ!凄い人が来日したんだね。

今話題のChatGPTをめぐって、すごいねと好意的な意見も、安全性について批判的な意見も渦巻いているところへ、ニュースが飛び込んできました。

OpenAIが「バグ報奨金プログラム」の開始を発表したのです。

最高報酬額は2万ドル(およそ270万円)。最近このプログラムに参加した人は合計約1400人にのぼります。(2023年4月14日現在)

支払われた報奨金の平均が1054ドル(およそ14万円)です。

この記事では、OpenAIが開始した「バグ報奨金プログラム」の内容とその背景を解説します。

この記事でわかること

✅バグ報奨金プログラムの内容

✅バグ報奨金プログラムを開始した背景

✅サム・アルトマン来日の理由

ChatGPTをめぐって世界でいろんな動きがある中、OpenAI側の声を聞いてみましょう。

バグ報奨金プログラムの内容

ChatGPTを開発したOpenAIは、バグ報奨金プログラムを開始すると発表しました。(2023,4,11)

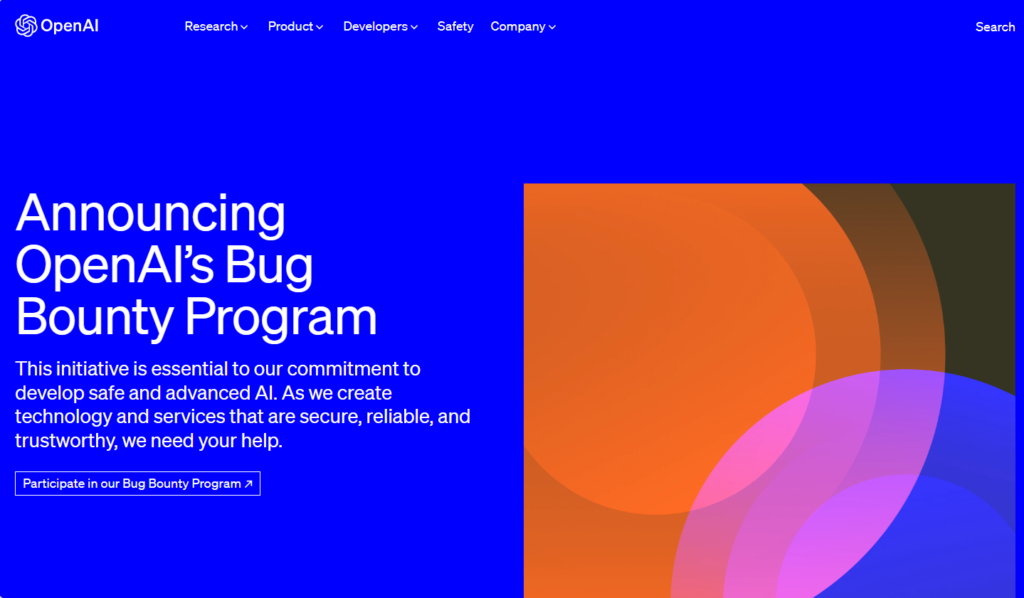

この取り組みは、安全で高度なAIを開発するという私たちのコミットメントに不可欠です。安全で信頼性が高く、信頼できるテクノロジーとサービスを作成する際には、お客様の支援が必要です。

This initiative is essential to our commitment to develop safe and advanced AI. As we create technology and services that are secure, reliable, and trustworthy, we need your help.

OPenAI,バグ報奨金プログラム発表から引用

AIを保護するための取り組み

「OpenAIの使命は、すべての人に利益をもたらす人工知能システムをつくること」と、創業当時からずっとこのポリシーできています。

そのために、研究と技術に多額の投資をしていると言っています。

ただし、他の複雑なテクノロジーと同様に、脆弱性や欠陥が発生する可能性があることを理解しています。

However, as with any complex technology, we understand that vulnerabilities and flaws can emerge.

OpenAI,バグ報奨金プログラム発表から引用

私たちは、この現実に対処するには、透明性とコラボレーションが不可欠であると信じています。そのため、セキュリティ研究者、倫理的ハッカー、テクノロジー愛好家のグローバルコミュニティを招待して、システムの脆弱性を特定して対処するのを手伝ってもらいましょう。

We believe that transparency and collaboration are crucial to addressing this reality. That’s why we are inviting the global community of security researchers, ethical hackers, and technology enthusiasts to help us identify and address vulnerabilities in our systems.

OpenAI,バグ報奨金プログラム発表から引用

バグ報奨金プログラムの紹介

OpenAIバグ報奨金プログラムは、当社のテクノロジーと会社の安全維持に貢献しているセキュリティ研究者の貴重な洞察を認識し、報いるための方法です。システムで発見された脆弱性、バグ、またはセキュリティ上の欠陥を報告することをお勧めします。調査結果を共有することで、当社のテクノロジーをすべての人にとってより安全にする上で重要な役割を果たします。

The OpenAI Bug Bounty Program is a way for us to recognize and reward the valuable insights of security researchers who contribute to keeping our technology and company secure. We invite you to report vulnerabilities, bugs, or security flaws you discover in our systems. By sharing your findings, you will play a crucial role in making our technology safer for everyone.

OpenAI,バグ報奨金プログラム発表から引用

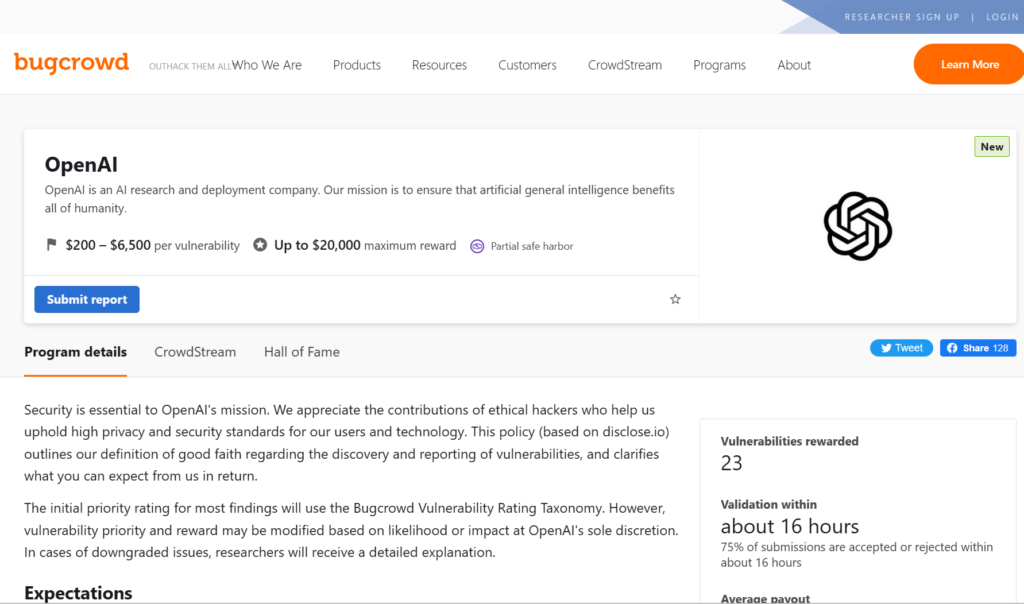

どのようにこのプログラムは運営されているかというと、大手の報奨金プラットフォーム「Bugcrowd」と連携しています。

参加に関する詳細は、BugcrowdのWEBサイトにあります。

、BugcrowdのWEBサイトにいくと、詳細なガイドラインが書いてあります。

ほとんどの検出結果の最初の優先度評価は、Bugcrowdの 脆弱性評価分類に基づき評価されます。

OpenAIが、精査依頼している項目は6つです。

①API ターゲット

②ChatGPT

③第三者を通じて公開される可能性のある機密のOpenAI企業情報

④OpenAI API キー

⑤OpenAIの研究組織によるWEBサイトやサービス

⑥その他のOpenAI関連

また、禁止事項の説明や、細かくルールの遵守が求められています。

インセンティブと報酬

報酬金額は、各項目ごとの脆弱性評価によって変わってきます。

最低200ドル(およそ2万7000円)から、最高2万ドル(およそ270万円)までの範囲で設定されています。

テストを奨励し、感謝の印として、報告された問題の重大度と影響に基づいて現金報酬を提供します。私たちの報酬は、重大度の低い発見に対する200ドルから、例外的な発見に対する最大20,000ドルの範囲です。私たちはあなたの貢献の重要性を認識し、あなたの努力を認めることをお約束します。

To incentivize testing and as a token of our appreciation, we will be offering cash rewards based on the severity and impact of the reported issues. Our rewards range from $200 for low-severity findings to up to $20,000 for exceptional discoveries. We recognize the importance of your contributions and are committed to acknowledging your efforts.

OpenAI,バグ報奨金プログラム発表から引用

共に安全を保つ

OpenAIでは、セキュリティの決定的な重要性を認識しており、それを共同作業と見なしています。セキュリティ研究コミュニティの皆さんには、バグ報奨金プログラムへの参加を呼びかけています。

At OpenAI, we recognize the critical importance of security and view it as a collaborative effort. We invite the security research community to participate in our Bug Bounty Program.

OpenAI,バグ報奨金プログラム発表から引用

「このプログラムは、皆さんとの共同作業ですから、一緒に安全性を保ちましょう。参加してください。」と、書いてあります。

バグ報奨金プログラムを出した背景

4月11日にバグ報奨金プログラムを発表するまでの経緯を、簡単に説明しましょう。

3月24日のOpenAIの発表によると、3月20日のごく短い時間にChatGPTの有料プランである「ChatGPT Plus」を利用している一部のユーザーの個人情報が流出した可能性があることを明らかにしました。

3月30日には、イーロン・マスクらが、AIの開発停止を求める公開書簡に署名したとのニュースが流れました。

AIの開発停止を求める公開書簡の内容は、こちらの記事にまとめています。

そのあとも、イタリアでChatGPTの使用を一時停止にしたり、ニューヨーク、パリの学校が使用を禁止したり、日本でも大学やNTTドコモなどが原則使用禁止にしています。

ネガティブキャンペーンが繰り広げられている中、4月5日にOpenAIは、「AIの安全性に対する当社の取り組み」を発表しました。

それがこちらです。

■AIの安全性に対する当社の取り組みhttps://openai.com/blog/our-approach-to-ai-safety

「AIの安全性に対する当社の取り組み」の内容

ChatGPTは公表されてから急速に多くの人に使われるようになり、良い評価も悪い評価もたくさん出ました。

特に、イーロン・マスクらが署名した公開書簡が挙げてきた提案に対して、回答するような形で「AIの安全性に対する当社の取り組み」は書かれています。

安全性を高めるAIシステムの構築

署名運動の公開書簡の主張はこうです。

高度なAIを作っていくためには、計画して管理されているというのは非常に重要です。

残念ながら、そのようなことは全然行われていません。

私たちはすべてのAIラボに対し、GPT-4よりも強力なAIシステムの訓練を少なくとも6か月間、直ちに一時停止するよう呼びかけます。

これに対して、OpenAIでは

新しいシステムをリリースする前に、厳格なテストを実施し、外部の専門家にフィードバックを求め、人間のフィードバックによる強化学習などの手法を使用してモデルの動作を改善し、幅広い安全および監視システムを構築します。

Prior to releasing any new system we conduct rigorous testing, engage external experts for feedback, work to improve the model’s behavior with techniques like reinforcement learning with human feedback, and build broad safety and monitoring systems.

AIの安全性に対する当社の取り組み

たとえば、最新モデルのGPT-4がトレーニングを終了した後、公開する前に、組織全体で6か月以上かけて、より安全で整合性の高いものにしました。

For example, after our latest model, GPT-4, finished training, we spent more than 6 months working across the organization to make it safer and more aligned prior to releasing it publicly.

AIの安全性に対する当社の取り組み

「ちゃんと計画的に管理してやってるよ。」と、OpenAIは言っています。

実際の使用から学び、安全対策を改善

直ちに6か月間の一時停止を求めるという公開書簡に対しては、

展開前に予測可能なリスクを防ぐために懸命に取り組んでいますが、ラボで学べることの限界.広範な研究とテストにもかかわらず、すべてを予測することはできません。人々が私たちの技術を使用する有益な方法、または人々がそれを悪用するすべての方法。そのため、実際の使用から学ぶことは、時間の経過とともに安全性が増すAIシステムを作成およびリリースするための重要な要素であると考えています。

We work hard to prevent foreseeable risks before deployment, however, there is a limit to what we can learn in a lab. Despite extensive research and testing, we cannot predict all of the beneficial ways people will use our technology, nor all the ways people will abuse it. That’s why we believe that learning from real-world use is a critical component of creating and releasing increasingly safe AI systems over time.

AIの安全性に対する当社の取り組み

「ラボで学ぶには限界がある。だから、一時停止するのではなく、実際に使ってもらって学ぶことが重要だ。」と、OpenAIの主張です。

公開書簡では、

・AI情報にあふれる世の中でいいのか

・楽しい仕事もすべて自動化すべきか

・「非人間的な精神」を開発すべきか

・文明のコントロールを失うリスクを冒すか

という問いかけがありました。

それに対しOpenAIは、

重要なのは、社会はますます高性能なAIを更新して適応する時間が必要であり、このテクノロジーの影響を受けるすべての人がAIがさらに発展する方法について重要な発言権を持つべきであると私たちは信じています。

Crucially, we believe that society must have time to update and adjust to increasingly capable AI, and that everyone who is affected by this technology should have a significant say in how AI develops further.

AIの安全性に対する当社の取り組み

公開書簡が問いかけるAI情報にあふれるとの意見について、

「ChatGPTは独自のサービスとAPIを利用できるようにしているから、いろんなアプリ開発が出来ている。それによって誤った使い方を監視することもできる。」

「現実の社会で、テクノロジーを有益に使うことは、ある程度社会が適応する時間が必要だ。」

「AIによって影響を受ける人たちが、発言権を持つべきだと思う。」

など、この項目は一番ボリュームが多い部分でした。

子どもの保護

ここからは、公開書簡への回答ではなく、実際にユーザー側から聞こえてきたネガティブな意見に対して回答しています。

私たちの安全への取り組みの重要な焦点のひとつは、子供を保護することです。 AI ツールを使用するには、18 歳以上 (または保護者の承認を得た 13 歳以上) である必要があり、検証オプションを検討しています。

One critical focus of our safety efforts is protecting children. We require that people must be 18 or older—or 13 or older with parental approval—to use our AI tools and are looking into verification options.

AIの安全性に対する当社の取り組み

たとえば、ユーザーが児童の性的虐待の素材を画像ツールにアップロードしようとすると、ブロックされ、全米行方不明および被搾取自動センターに報告されるようです。

また、学校の先生や学生に対しても

デフォルトの安全ガードレールに加えて、非営利の Khan Academy などの開発者と協力して、学生向けの仮想教師と教師向けのクラスルームアシスタントの両方として機能する AI を構築しました。 使用事例。 また、開発者がモデル出力に対してより厳しい基準を設定できるようにする機能にも取り組んでおり、そのような機能を必要とする開発者とユーザーをより適切にサポートします。

In addition to our default safety guardrails, we work with developers like the non-profit Khan Academy—which has built an AI-powered assistant that functions as both a virtual tutor for students and a classroom assistant for teachers—on tailored safety mitigations for their use case. We are also working on features that will allow developers to set stricter standards for model outputs to better support developers and users who want such functionality.

AIの安全性に対する当社の取り組み

と、開発途中ではあるものの、サポートするよと言っています。

OpenAIのCEOであるサム・アルトマンが来日し、『研究者や学生などへの研修・教育提供』を日本に提案していました。

この部分が、日本への提案の一部になっています。

プライバシーの尊重

トレーニング データの一部には公共のインターネットで入手可能な個人情報が含まれていますが、私たちのモデルは個人ではなく世界について学習する必要があります。 そのため、可能な場合はトレーニング データセットから個人情報を削除し、モデルを微調整して、個人の個人情報の要求を拒否し、個人からの個人情報をシステムから削除する要求に対応します。 これらの手順により、モデルが個人の個人情報を含む応答を生成する可能性が最小限に抑えられます。

While some of our training data includes personal information that is available on the public internet, we want our models to learn about the world, not private individuals. So we work to remove personal information from the training dataset where feasible, fine-tune models to reject requests for personal information of private individuals, and respond to requests from individuals to delete their personal information from our systems. These steps minimize the possibility that our models might generate responses that include the personal information of private individuals.

AIの安全性に対する当社の取り組み

「大規模言語モデルは、いろんなコンテンツでトレーニングされていて、さらに改善はしているものの、一部のトレーニングデータには、個人情報が含まれてるので、可能ならば削除します。個人情報の要求も拒否、削除要請にも対応します。」とのことです。

事実の正確性の向上

これは、よく言われていることですね。ChatGPTは、「間違った内容をしれっと言う」などと言われていました。

今日の大規模な言語モデルは、ユーザーが指定したテキスト入力など、以前に見たパターンに基づいて次の一連の単語を予測します。場合によっては、次に可能性の高い単語が事実上正確ではない可能性があります。

Today’s large language models predict the next series of words based on patterns they have previously seen, including the text input the user provides. In some cases, the next most likely words may not be factually accurate.

AIの安全性に対する当社の取り組み

ユーザーがツールを使用するためにサインアップする場合、ChatGPTが常に正確であるとは限らないことを可能な限り透明にするよう努めています。

When users sign up to use the tool, we strive to be as transparent as possible that ChatGPT may not always be accurate.

AIの安全性に対する当社の取り組み

継続的な研究と関与

より高性能なモデルの作成と展開にはますます慎重になり、AIシステムの進化に合わせて安全対策を強化し続けます。

We will be increasingly cautious with the creation and deployment of more capable models, and will continue to enhance safety precautions as our AI systems evolve.

AIの安全性に対する当社の取り組み

GPT-4の能力、利点、リスクをよりよく理解するために6か月以上待ったが、AIシステムの安全性を向上させるためにそれ以上の時間がかかる場合がある。したがって、政策立案者とAIプロバイダーは、AIの開発と展開が世界規模で効果的に管理され、誰も前進するために手抜きをしないようにする必要があります。これは、技術的イノベーションと制度的イノベーションの両方を必要とする困難な課題ですが、私たちが貢献したいと熱望している課題です。

While we waited over 6 months to deploy GPT-4 in order to better understand its capabilities, benefits, and risks, it may sometimes be necessary to take longer than that to improve AI systems’ safety. Therefore, policymakers and AI providers will need to ensure that AI development and deployment is governed effectively at a global scale, so no one cuts corners to get ahead. This is a daunting challenge requiring both technical and institutional innovation, but it’s one that we are eager to contribute to.

AIの安全性に対する当社の取り組みを説明

このような、AIに対する安全対策を発表したあとの、バグ報奨金プログラムの開始となったのです。

サム・アルトマン来日の理由

OpenAIのCEOであるサム・アルトマンが来日しました。

いろんな批判を受けながらも、便利だという評価もあり、OpenAIの取り組みを理解してもらうためと、各国政府と対話するために、サム・アルトマンは世界を回るツアーをしています。

その一番最初に選んだ国が日本だったのです。

OpenAIから見て日本はどう映るのか、OpenAIのChatGPT技術幹部であるシェイン・グウさんの話が詳しいです。

シェイン・グウさんは、日本生まれの中国系カナダ人で、以前はグーグルのAI研究部門にいましたが、今年になってOpenAIに移籍した、若き天才です。

シェインさんは小学校6年生まで日本にいて、ドラえもんを見て育ったといいます。

「ドラえもんを見ている国民だから、日本人はAIやロボットに対して嫌悪感がない、むしろ好意的だ。」

と、言っています。

「ChatGPTのAPIコードを公開した時、日本ではいろんなアプリを開発したと毎日のようにSNSにあがっていてびっくりしたし嬉しかった。」

「日本人は、物づくりが得意でそれが強みだ。」

と言っています。さらに、

「日本ができることは、いっぱいあります。OpenAIと日本はお互いに興味があります。」

と、言っています。

一番興味がある国として、サム・アルトマンは訪問先の一番目を日本にしたのかもしれません。

それだけが理由ではなく、日本人のAIに対する反応についても、

「みなさん、ChatGPTをぜひ使ってください。使ってみたら意外と面白いので。AIの面白さを素直に喜べる、物に対して感動できるというのは、日本の独自なところだと思っています。」

欧州では批判されていますが、日本はAIを受け入れやすい国民性だから、日本での活動に意欲が出たのでしょう。

サム・アルトマンは、来日して語っていたのは、主に以下の内容です。

・日本法人の設立の検討

・ChatGPTの日本語などの改善

・政府が公開しているデータなどを分析提供

・研究者や学生などへの研修・教育提供

いろんな立場の人が、さまざまな事を言いますが、サム・アルトマンが日本に好意的だというのは、素直に喜んでいいのではないでしょうか。

まとめ

OpenAIがバグ報奨金プログラムを発表したのは、

・イーロン・マスクがら署名した公開書簡で、問題性を指摘され、応えるようなかたちで改善しようと動いた

・OpenAIとしては、AIの開発は一時停止するのではなく、多くの研究者またはユーザーに触れてもらい問題点を発見した方がいいと判断したから

今後しばらくは、OpenAIは話題の中心でしょう。

『GPTを三井住友グループとマイクロソフトが発表』というニュースもありました。

これからの時代は、AIが標準装備になる可能性が大です。

AIを使いこなせる人は、今後まわりから重宝がられるでしょう。

できれば、そっち側にいたいなと思う今日この頃です。

長い記事を読んでくださりありがとうございました。